Ollama 是一款可以在本地运行大语言模型的开箱即用工具,你可以运行 Llama 3.3, DeepSeek-R1, Phi-4, Mistral, Gemma 2等开源模型。

进入ollama 官网 进行下载,ollama 支持 Liunx、mac、windows. 你只需要选择适合自己的平台进行安装即可,非常简单快捷。

使用Ollama很简单,只需要在命令行页面输入 ollama run 模型名称,如运行:ollama run llama3.2,如果要运行的模型没有安装,ollama 会帮你自动安装后运行模型。

你可以在官网查找支持的模型:https://ollama.com/search 。

在控制台输入:/bye 即可退出对话。

Open WebUI 是一个可扩展、功能丰富、用户友好的自托管人工智能平台,可完全离线运行。它支持各种 LLM 运行程序,如 Ollama 和 OpenAI 兼容 API,并内置 RAG 推理引擎,是一个强大的人工智能部署解决方案。

Open WebUI 可以使用 Python 软件包安装程序 pip 进行安装。在继续之前,请确保您使用的是 Python 3.11,以避免兼容性问题。

pip install open-webui

启动服务:

open-webui serve

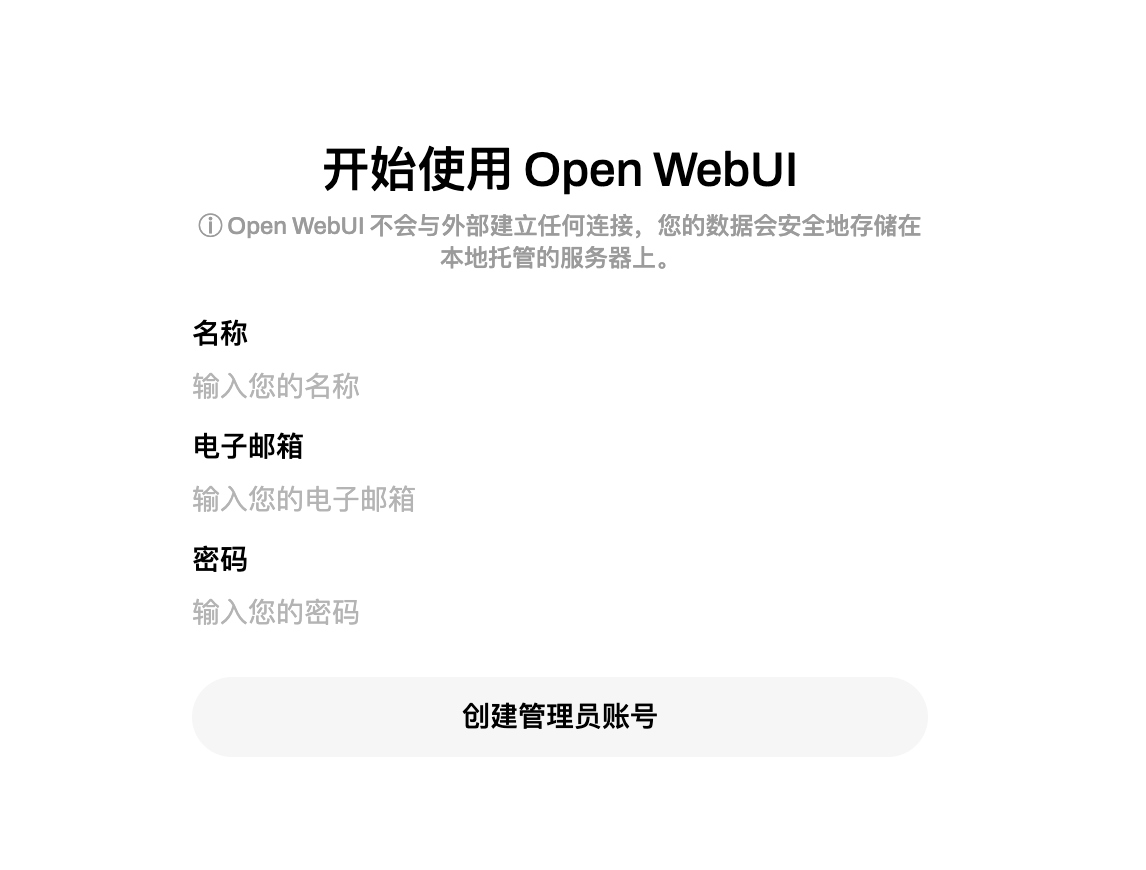

启动服务完成后,在浏览器输入 http://localhost:8080/ 打开。第一次使用需要创建管理员密码,这一步很简单。

具体安装方式可以查看官方文档地址:https://docs.openwebui.com/

进入聊天界面后,界面左侧上方可以选择模型,这里的模型就是上面ollama安装的模型,非常方便。

使用 Ollama 和 Open WebUI 非常方便的在本地部署大模型和使用大模型。

本文采用 CC BY-NC-SA 4.0 许可协议。转载请注明出处!

本文主要介绍如何使用openaisdk,如何调用第三方deepseek,通义千问等服务,以及如何在浏览器端处理流式响应,这是打造自己的聊天助手的基础,本文使用的版本是js版本,部分代码需要在nodejs环境运行。认识openaisdkopenaisdk是OpenAI官方提供...

最近DeepSeek火的不要不要的,之前的科大讯飞、百度的文心一言、Kimi等没有让更多的普通用户对AI产生兴趣,反而是DeepSeek的出现让更多的用户了解到了AI的强大,越来越多的用户开始使用AI,并探索AI的强大功能。本文将介绍如何使用browser-use和Deep...